Info) 아래 포스팅은 LGAimers에서 제공하는 AI 전문가 과정 중 한양대학교 배석주 교수님의 [품질과 신뢰성] 강의를 정리한 것입니다. 정리된 내용들은 강의를 토대로 작성되었으나 수강자인 저의 이해도에 따라 일부 틀린 부분이 있을 수 있다는 점 알려드립니다. 잘못된 점이 발견될 시에는 즉각 수정하도록 하겠습니다.

1. 신뢰성 분포와 신뢰성 척도

1.1 지수분포

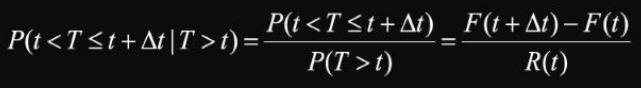

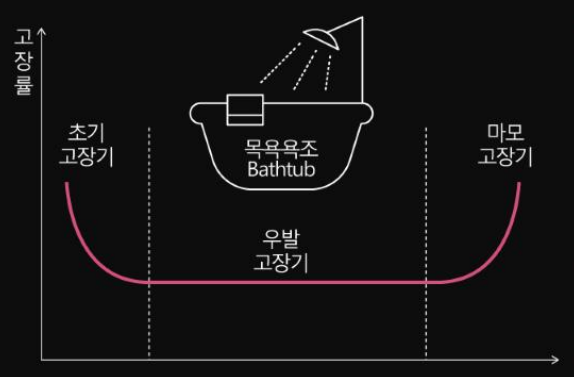

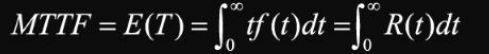

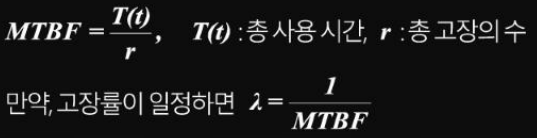

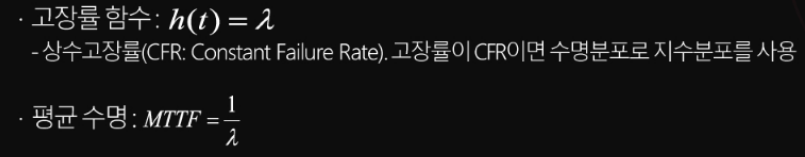

지수분포는 첫번째 고장이 발생하기까지의 시간을 의미하며 지수분포의 고장률 함수는 t시간에 관계없이 일정하게 나타난다. 시간에 영향을 받지 않는 고장률은 지수분포가 유일하다. 지수분포는 욕조곡선에서 우발 고장기를 잘 설명하는 함수이다. 아래와 같이 고장률 함수는 고정적인 람다값을 가질 때 평균 수명은 람다의 역수값을 가지게 된다.

1.2 지수분포의 무기억성(Memoryless property of exponential distribution)

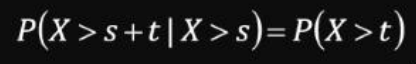

이산형 분포에서 기하분포가 무기억성을 갖는 반면 연속형 분포에서는 지수분포가 무기억성을 가지게 된다. 확률변수 X가 지수분포를 따른 다는 가정하에서 양의 실수 s, t에 대해서 다음과 같은 무기억성이 성립되는데 s까지 고장이 나지 않은 제품이 s+t까지 고장나지 않고 계속 사용가능할 확률은 이전의 시간 s와 관계없이 t까지 고장이 나지 않을 확률과 똑같다고 할 수 있다. 즉, 이전의 정상 작동 시간에 대한 기억을 고려하지 않은 것이다.

가령, 버스 도착시간이 시간 당 6대인 지수분포를 따른다고 가정해보겠다. 이는 10분당 1대가 도착한다는 것을 의미하게 된다. 정류장에 도착해 5분을 기다려도 버스가 도착하지 않았다고 하면 이후 2분을 더 기다려서 버스가 도착할 확률은 처음 정류장에 도착해 2분을 기다려 버스가 도착할 확률과 같다. 이러한 지수분포의 무기억성 때문에 마모 과정에 대한 기억을 누적해야 하는 마모고장의 경우 지수분포를 도입할 수 없게 된다.

1.3 지수분포와 포아송분포의 관계

지수분포는 어떤 사건이 발생하기까지 걸린 시간에 대한 분포를 표현하는데 사용된다. 이러한 발생 빈도를 나타내는 람다는 포아송 분포에서도 같은 의미로 사용되는데 포아송분포는 발생빈도에 따라 단위시간동안 발생하는 사건의 수를 나타낸다. 즉, 단위시간 당 발생한 사건 수를 역으로 보게 되면 한 사건이 발생하는데 걸린 시간으로 볼 수 있고 때문에 포아송 프로세스에서 첫번째 사건이 발생하는데 걸린 시간은 지수분포를 따른다고 할 수 있다.

1.4 품질과 신뢰성 관점에서 지수분포

지수분포의 관점에서 사용된 제품은 확률적으로 새 것과 같기 때문에 작동하고 있는 부품을 예방보전의 목적으로 미리 교체할 필요는 없다. 신뢰도 함수, 고장까지의 평균 시간을 추정하는데 있어 관측시점에서 부품들의 총 작동시간과 고장의 수에 대한 데이터만 있다면 충분히 계산될 수 있다. Drenick의 정리에 따르면 여러 개의 다른 형태의 부품으로 구성된 복잡한 기기나 시스템의 수명분포는 넒은 조건하에서는 근사적으로 지수분포를 따른다고 할 수 있다. 이처럼 지수분포는 수학적으로 계산하기 비교적 쉽기 때문에 많은 전자부품의 고장을 모형화하는데 활용되고 있다.

1.5 감마 분포(Erlang Distribution)

어떤 사건이 포아송분포 하에 있다고 하면 k개의 사건이 발생하는데 까지 걸린 시간은 지수분포를 일반화한 감마 분포를 따른다고 할 수 있다. 정리하면 서로 독립인 확률변수 x1, x2...xk가 지수분포를 따를 때 지수확률변수의 합은 감마분포를 따르게 된다. 예를 들어, 시간당 평균 30명의 고객이 방문하는 포아송 분포를 따르는 가게가 있다고 할 때 처음 2명의 고객이 방문할 때까지 5분 이상의 시간이 걸릴 확률은 감마분포로 표현이 가능하다. 왜냐하면 시간당 30명의 고객이 방문한다는 것은 한 고객이 방문하는데 2분이 걸리는 지수분포를 따르게 되기 때문이다.

1.6 와이블 분포(Weibull Distribution)

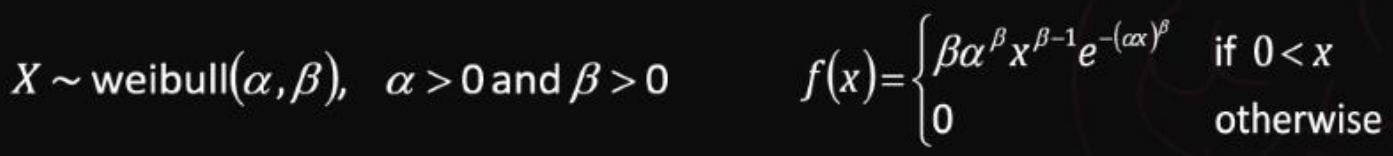

확률변수 X가 아래 식과 같은 확률밀도함수를 가질 때 와이블 분포를 따른다고 한다. 이때 알파값은 척도에 영향을 주는 척도모수(Scale parameter)이며 베타값은 형상에 영향을 주는 형상모수(Shape parameter)이다.

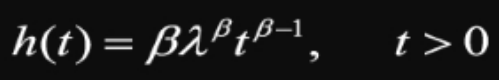

와이블 분포에서 고장률 함수는 아래 식과 같다. 이때 배타값에 따라 고장률의 변화양상이 다르게 나타나는데 베타가 1보다 큰 경우 고장률은 증가하게되고 베타가 0과 1사이인 경우 고장률은 감소하게 된다. 마지막으로 베타가 1인 경우에는 고장률이 t에 관계 없이 일정하게 되는데 지수분포와 동일한 형태를 띠게 된다. 따라서 지수분포는 형상모수가 1인 와이블 분포라고 정리할 수 있다.

와이블 분포는 신뢰성 데이터 분석에서 가장 많이 사용되는 분포함수이다. 그리고 앞서 살펴보았던 것처럼 형상모수인 베타값에 따라 다른 여러 분포 형태를 보이게 된다. 베타가 1인 경우는 지수분포, 2인 경우는 레일리 분포, 3보다 큰 경우 정규분포에 근사하게 된다. 와이블 분포는 주로 볼 베어링이나 모터와 같은 기계 부품의 피로 고장이나 화학적 반응으로 고장이 생기는 경우에 많이 적용된다. 한편, 지수분포는 와이블 분포와 활용 범위의 차이가 있다. 지수분포는 어셈블리와 시스템의 수명분포를 나타내는데 주로 사용되는 반면, 와이블분포는 부품의 수명분포를 나타내는데 사용된다.

1.7 정규분포(Normal Distribution)

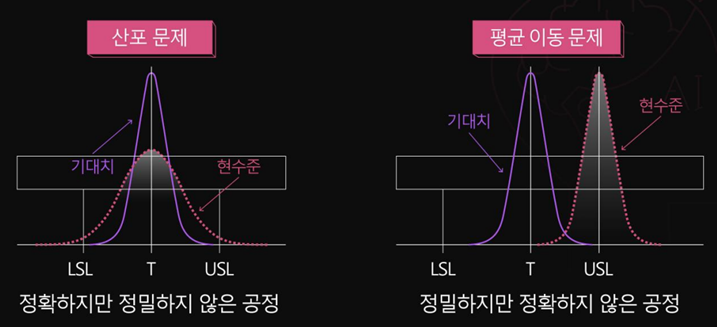

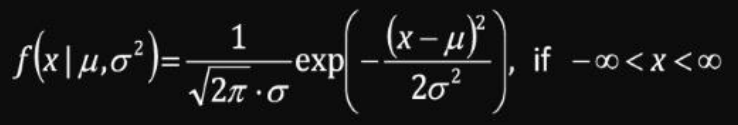

확률변수 X가 아래와 같은 확률밀도함수를 가질 때, 평균과 표준편차의 제곱으로 정규분포를 표현할 수 있다. 정규분포는 중심이 평균 뮤이고 좌우대칭인 종모양의 형태를 띠게 된다. 이때 표준편차의 제곱인 분산값이 분포의 형태에 영향을 주게 되는데 분산이 크면 위아래가 짧고 좌우로 넓게 퍼진 형태를 보이며 반대로 분산이 작으면 위아래가 높고 좌우가 좁은 뾰족한 형태를 띠게 된다.

정규분포에서 특히 평균이 0이고 분산이 1인 특별한 케이스를 표준정규분포(standard normal distribution)이라고 한다. 표준정규분포를 따르는 확률변수 z에 대한 확률밀도함수 또는 누적분포함수를 알고 있으면, 모든 정규분포의 확률을 계산할 수 있다.

정규분포에서 독특한 특징 중 하나는 중심극한정리에 의해 표본평균의 분포가 정규분포에 근사해진다는 점이다. n개의 표본이 추출되는 데이터의 분포가 정규분포가 아닌 다른 임의의 분포라고 하더라도 n의 수가 충분히 크다면 표본평균의 분포는 근사적으로 정규분포를 따른다고 할 수 있다. 일반적으로 n이 30이상이면 정규분포에 근사한다고 말할 수 있으며 표본의 분포가 정규분포 형태를 띠고 있으면 n이 3이하여도 정규분포에 근사하게 된다.

확률변수 X에 log를 취한 값이 정규분포를 따르면 이를 대수정규분포를 다른다고 하게 되는데 대수정규분포는 다양한 형태의 분포를 표현할 수 있기 때문에 고장데이터를 모형화하는데 많이 활용되며 반도체 고장이나 금속 부식, 크랙의 성장 등으로 발생하는 고장을 표현하는데 자주 사용된다.

1.8 베르누이와 이항분포

위에서 살펴본 분포들은 연속형 분포를 표현한 것들인데 반해 결과값이 성공과 실패와 같이 binary의 이산형 분포를 가지게 되면 이를 베르누이 확률변수라고 한다. 그리고 n개의 베르누이 확률변수의 합은 이항분포(Binomial distribution)로 나타낼 수 있다.

1.9 포아송 분포(Poisson Distribution)

포아송 분포는 이전 절에서 살펴본 지수분포의 역 형태로 한 단위 동안 발생한 사건의 개수를 확률변수로 가지는 분포이다. 가령, 학교 주차장에 한 시간 동안 들어오는 차량의 대수, 교량을 지지하는 20m 강철선에서 결함의 개수, 반도체 웨이퍼에 발생하는 결함의 개수 등 단위 시간, 면적 동안 발생하는 평균 사건의 수를 예로 들 수 있다. 포아송 분포는 그 확률 질량함수의 평균과 분산이 뮤로서 같다는 독특한 특징을 가지고 있다.

2. ICT기반 예지보전

2.1 시스템 열화

우리가 사용하는 제품들과 시스템은 사용시간과 빈도가 증가함에 따라 열화하게 된다. 그리고 이 열화가 내재된 강도를 초과하게 되면 시스템은 고장하게 된다. 더 이상 요구된 기능을 수행하지 못하는 상태에 이르게 되는 것이다. 시스템의 단 한 부분이 고장이 나더라도 그로 인해 전체 시스템에 영향을 주어 시스템이 작동을 중단하게 되고 심한 경우 시스템 사용자의 안전까지 위협하게 된다.

2.2 보전의 목적

위와 같은 열화로 인한 시스템 고장으로 발생하는 인명 피해를 최소화하기 위해 이를 사전에 예측하고 예방할 수 있는 보전에 대한 요구가 커지고 있다. 보전(maintenance)는 안전하고 경제적으로 운전될 수 있는 조건으로 장비를 유지하는 활동을 말한다. 보전 활동을 결정하는 주요 요소로는 비용검토와 관련된 문제 인식이 필요하다. 효율감소로부터 증가하는 경제적 손실이 유효 보수비용보다 큰지를 판단해야 한다. 그리고 saftey risk의 관점에서 사전보전조치에 의한 안전에 대한 위험 요소 회피가 필요하다 따라서 고장상태의 예측 방법론의 필요성이 대두되고 있다. 마지막으로 휴지기간비용(Downtime cost)와 수리비용(Repair cost)을 고려할 필요가 있다. 이익이 최대가 되고, 총비용이 최소가 되도록 할 수 있는 보전방법을 선택할 필요가 있고 창정비(overhaul)에 대한 보전비용이 고려될 피룡가 있는지 판단해야 한다.

2.3 보전방식의 분류

일반적으로 보전은 크게 사후보전(Breakdown maintenance)과 예방보전(Preventive maintenance)으로 구분된다. 사후보전은 점검 및 정기교환을 하지 않고 장비가 고장이 나면 수리를 하게 된다. 고장이 나도 그 영향이나 손실이 미미한 경우에 적합하며 열화 경향의 산포가 크고 점검 및 검사가 쉽지 않은 경우에 적용할 수 있다. 사후보전의 경우 장비의 수명이 다할 때까지 사용이 가능하기 때문에 2차 고장이 없다면 보전 수리비가 저렴하다는 이점이 있다. 하지만, 갑작스런 고장으로 장비 운용의 효율이 떨어지는 일이 발생할 수 있는 단점이 있다. 이와 달리 예방보전은 사전에 보전활동을 진행하는 경우를 말한다. 예방보전은 시간을 기준으로 예방보전을 진행하는 TBM(Time Based Maintenance)와 상태를 기준으로 예방보전을 진행하는 CBM(Condition Based Maintenance)으로 나뉘게 된다.

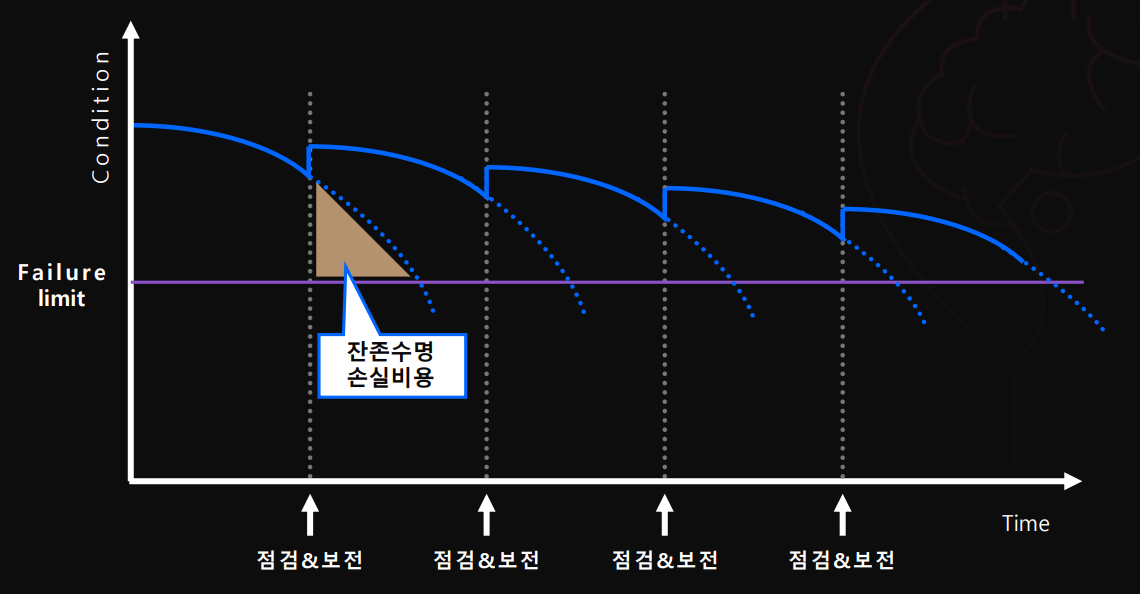

시간기준보전(TBM)은 장비의 열화에 영향을 주는 파라미터(ex. 베터리 사이클 순환, 프린터의 인쇄 수)를 기준으로 수리주기를 결정하고 주기마다 수리를 진행하는 것이다. 시간기준보전의 경우 가능한 한 자주 보전하는 정책으로서 보전주기와 기능열화주기가 일치하지 않을 수도 있기 때문에 잔존 수명에 대해 손실비용이 발생하고 과잉 보전이 될 수도 있다는 단점이 있다. 아래 그림에서 볼 수 있듯이 제품이 아직 사용이 가능한 수준임에도 불구하고 짧은 보전 주기로 부품을 교체하다보니 잔손수명에 대해 손실비용이 삼각형의 크기만큼 발생하게 된다. 예방보전 주기에 따라 발생하는 비용을 비교해보면 주기를 길게 유지하게 되면 보전비용은 감소하지만 고장 발생으로 인한 수리비용이 증가하고 생산에서의 기회비용이 발생하게 된다. 따라서, 이 둘 사이의 trade-off의 균형을 맞출 수 있는 보전 주기를 결정해야 한다.

앞서의 시간기준보전으로 인해 발생하는 손실비용을 최소화하기 위해 제품의 상태를 기준으로 보전을 진행하는 상태기준보전(CBM)을 진행할 수 있다. 상태기반보전은 장비의 열화 상태를 센서나 온라인 연결을 통해 측정하고 일정 수준에 도달하게 되면 수리를 진행하는 보전방식이다. ICT 기술을 통해 지속적인 모니터링을 하여 보전을 결정하기 때문에 과잉 보전을 방지할 수 있는 장점이 있다.

2.4 예지보전의 역할과 목적

예지보전은 실질적인 시스템의 운용 및 열화 상태에 따라 고장발생 시점을 사전에 예측하여 선행보전활동을 수행하는 것을 목표로 하고 있다. 이를 위해 설비의 열화를 측정하고 분석하여 설비의 잔여수명을 정확하게 예측해야 하며 이로써 고장 바로 직전에 유지보수를 실시하여 TBM과 사후보전 사이의 최소한의 비용을 발생시키게 된다. 한마디로 비용지향적인 보전활동이라고 할 수 있다.

2.5 예지보전의 절차

1) 예지보전의 목적이 고장을 예측하는 것인지 불량을 예지하는 것인지 결정

2) 예지 대상에 대해 유닛 단위로 검사하는지 부품 단위를 검사하는 지 결정

3) 관리하고자 하는 대상의 성능열화상태가 파악 가능한지와 그 양상을 파악

4) 열화의 형태로부터 최적의 파라미터를 선정

5) 파라미터의 측정 방법을 선택

6) 정기적으로 장비의 이상 유무를 측정

7) 파라미터와 기능 열화간의 상관관계를 측정결과를 통해 조사

8) 고장이라고 판단할 열화 경계값(Threshold)를 설정

9) 열화 기준값을 벗어난 대상을 분해 조사하고 상태를 체크

10) 데이터를 누적시키며 파라미터와 성능 열화 간의 상관 관계를 입증

11) 지속적으로 열화 상태를 관리하기 위한 경영 관리 시스템을 구축

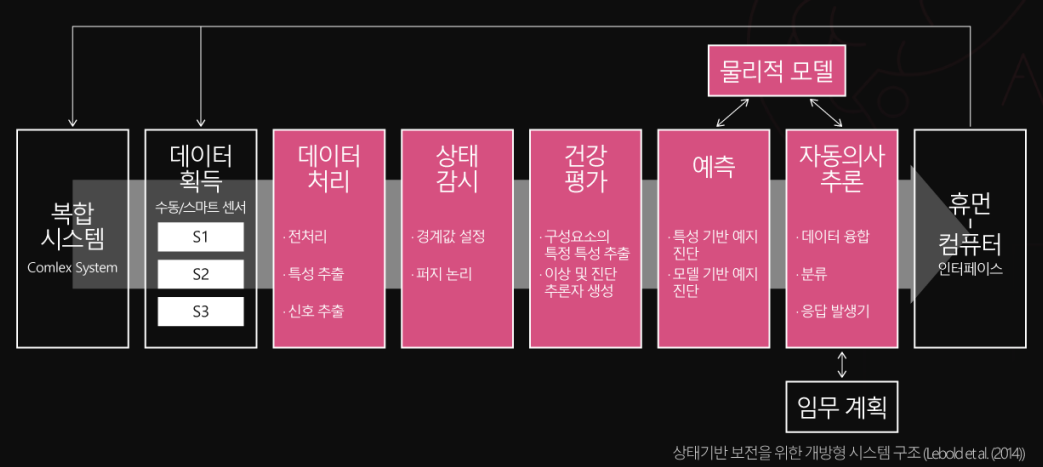

2.6 상태기반보전 프로세스

신호처리 프로세스 : 시스템에서 추출된 신호 데이터에는 잡음이 포함되어 있기 때문에 잡음을 제거하고 유의미한 특성을 추출하는 전처리 작업이 필요하다. 이때 많이 사용되는 기법으로 퓨리에 변환과 웨이블릿 변환이 있다. 웨이블릿 변환은 몇 개의 유의한 웨이블릿 계수로서 전체 신호를 나타낼 수 있기 때문에 데이터 축소 및 잡음 제거에 효과적인다. 사인, 코사인 함수를 기본 함수로 사용하기에 퓨리에 변환과 유사한 측면이 있지만 주파수 성분을 분해하고 해상도 성분을 파악할 수 있도록 비선형 변환을 한다는 점에서는 차이가 있다.

특징추출 프로세스: 산출된 웨이블릿 계수에 대해 특징 추출을 진행하는데 이때 허스트 지수를 사용할 수 있다. 허스트 지수는 각 수준에서 산출된 웨이블릿 계수의 분산에 대한 기울기이며 신호 데이터의 특정 구간에 대하여 웨이블릿 변환을 실시한 후 웨이블릿 계수의 분산에 대해 회귀분석을 실시하여 추정가능하다. 시스템의 이상여부를 감지하기 위해서는 다수의 주요 구성요소에 센서를 장착하여 다양한 특성치를 측정해야 하지만 차원이 커짐에 따라 특징추출이 쉽지 않게 된다. 다차원 데이터에 대한 차원축소의 방법으로 주성분분석(PCA)를 활용할 수 있다. 주성분분석은 변수의 공분산행렬을 직교분해함으로써 주성분이라 불리는 새로운 변수로 변환하는 것이다. 주성분분석은 잡음 데이터에 강건하며 변수간 상관관계를 가지는 문제(다중공선성)를 해결 가능하다. 또한, 데이터의 차원을 축소하고 상위 몇 개의 주성분만으로도 원변수의 변동을 80~90% 이상 설명할 수 잇는 장점이 있다.

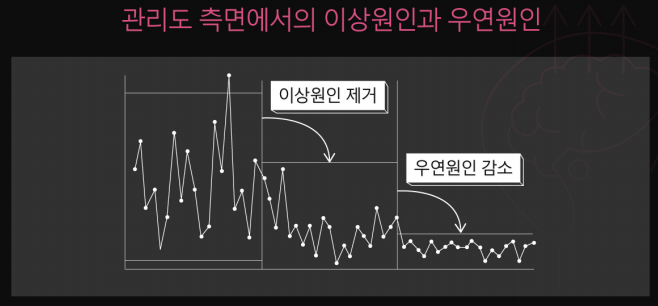

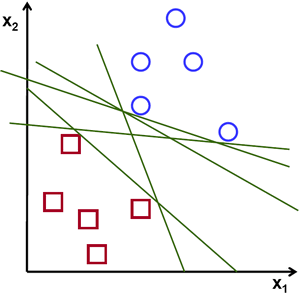

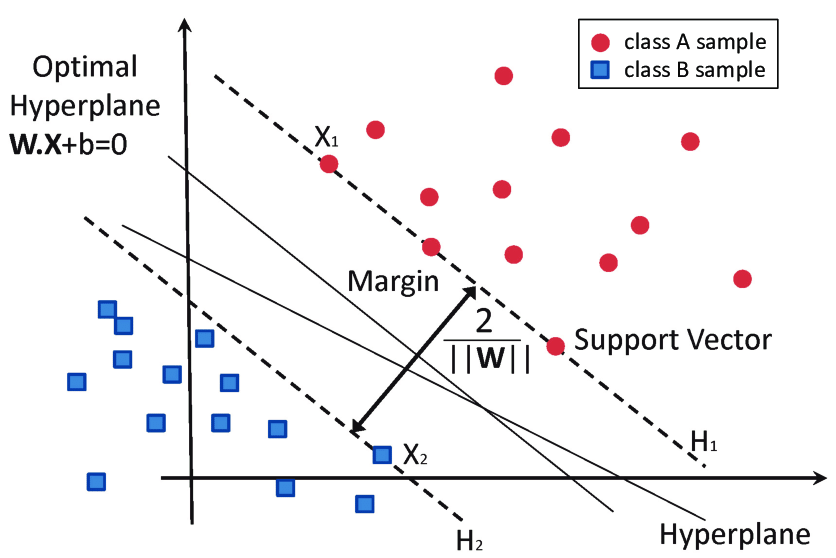

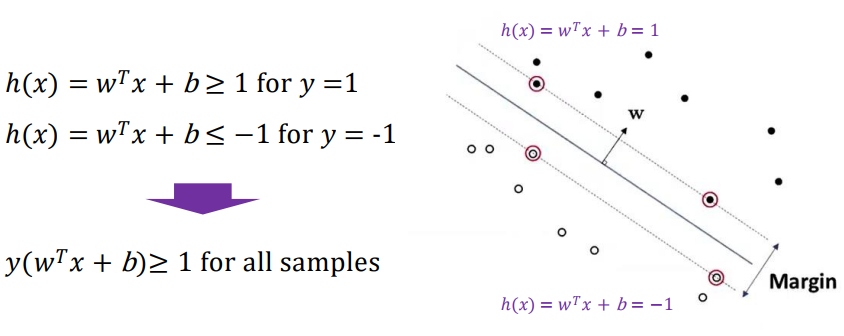

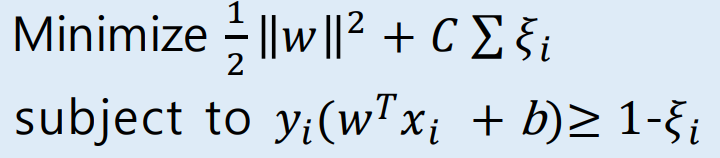

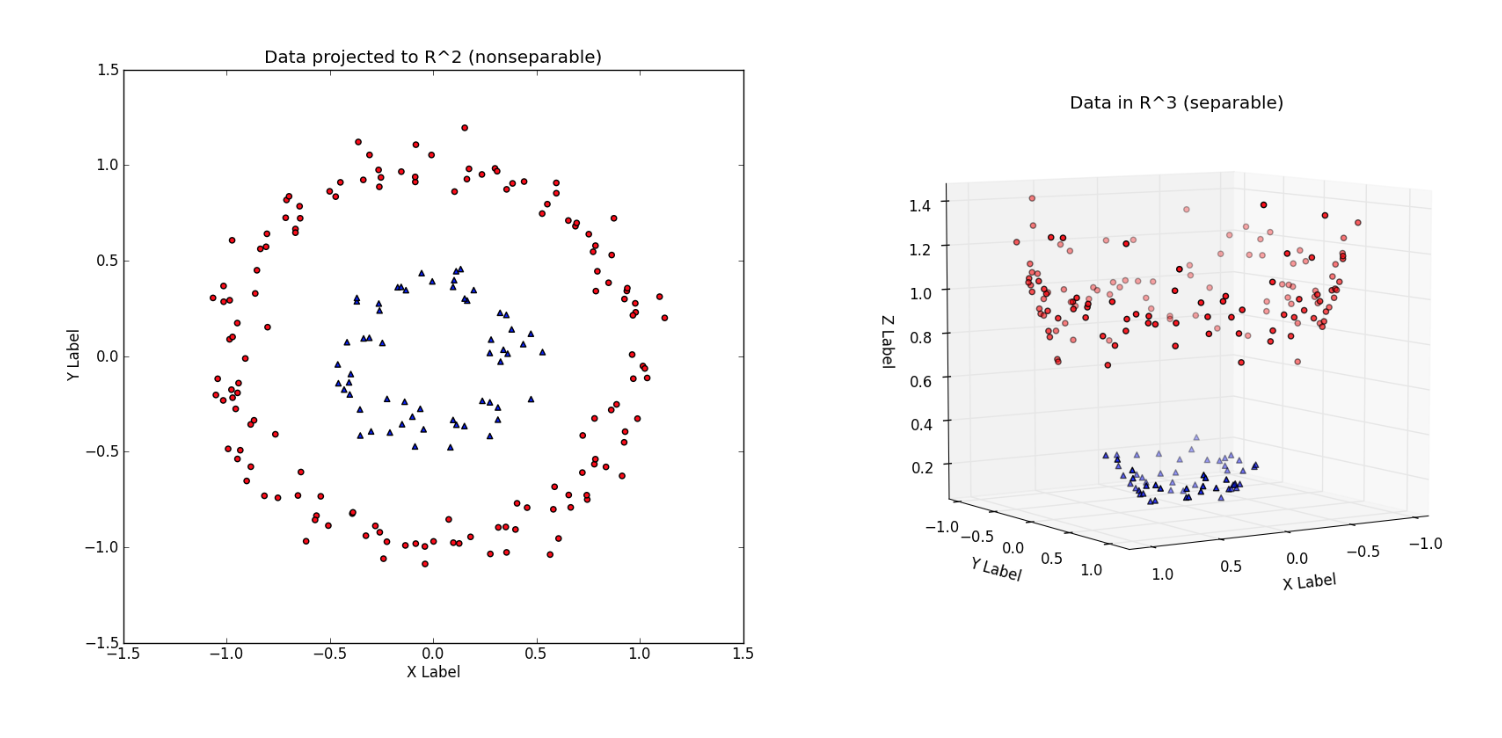

이상진단 및 예측 프로세스 : 추출된 특징에 대하여 고장 진단 및 예지를 할 수 있는 방법으로 관리도를 이용할 수 있다. 특징이 하나의 변수로 표현이 된다면 단변량관리도를, 여러 개의 변수로 표현이 된다면 다변량 관리도를 사용한다. 다변량 관리도 중 가장 많이 사용된는 것은 Hoteling의 T2관리도이며 신호 데이테로부터 추정된 통계량이 관리상한선을 초과한 경우 이상이 발생하였다고 판단한다. 이상 신호의 분류와 예측을 위해 ANN이나 SVM과 같은 머신러닝 기법 또는 CNN이나 Autoencoder과 같은 딥러닝 기법을 활용할 수 있다.

최적의사결정시스템 구축 프로세스 : 열화데이터 분석을 통한 설비의 고장시점이나 설비 신뢰도 예측 결과를 바탕으로 언제 설비를 어떻게 수리하는 것이 최적인지를 결정하는 의사결정 알고리즘을 개발할 필요가 있다. 보전 만족도와 비용을 고려하여 최대의 효과와 최소의 비용이 도출될 수 있도록 시스템을 구축해야 한다.

출처: LGAimers / https://www.lgaimers.ai/

'LGAimers' 카테고리의 다른 글

| [XAI] 2강 정리 및 소감 (0) | 2022.07.29 |

|---|---|

| [XAI] 1강 정리 및 소감 (0) | 2022.07.29 |

| [품질과 신뢰성] Part3 & 4 정리 (0) | 2022.07.27 |

| [품질과 신뢰성] Part1 & 2 정리 (0) | 2022.07.26 |

| [지도학습] Part 5. Advanced Classification 정리 및 소감 (0) | 2022.07.26 |